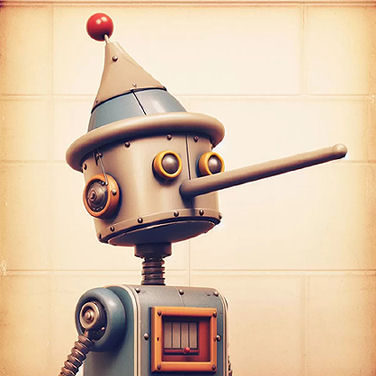

Esattamente come gli umani, anche l’intelligenza artificiale ha imparato a mentire. Si inventa cose che non esistono.

Esattamente come gli umani, anche l’intelligenza artificiale ha imparato a mentire. Si inventa cose che non esistono.

Il problema è sorto di recente, da quando il sistema sanitario nazionale americano (HHS) ha introdotto un modello di intelligenza artificiale chiamato ELSA (Efficient Language System for Analysis). Lo scopo di ELSA doveva essere quello di sveltire le pratiche di approvazione dei nuovi medicinali, conducendo ricerche su larga scala su tutta la documentazione scientifica già esistente.

Ma, finchè si tratta di fare il riassunto di migliaia di ricerche scientifiche già pubblicate, la Intelligenza Artificiale è sicuramente uno strumento molto efficace. Il problema nasce quando le si chiede di dare una sua valutazione sulla eventuale efficacia e sicurezza di un nuovo farmaco, perchè a quel punto si è scoperto che ELSA, molto disinvoltamente, si inventa anche ricerche scientifiche che non sono mai esistite.

In gergo, si chiamano “allucinazioni”. Ma sono vere e proprie bugie.

Dall’articolo della CNN leggiamo:

“Sei attuali ed ex funzionari della FDA hanno dichiarato alla CNN che Elsa può essere utile per generare appunti e riepiloghi di riunioni, o modelli di email e comunicati. Ma ha anche inventato studi inesistenti, noti come "allucinazioni" o ricerche travisate dall'IA. Questo la rende inaffidabile per il loro lavoro più critico, hanno affermato i dipendenti.”

"Tutto ciò che non si ha il tempo di ricontrollare è inaffidabile. Si inventa cose con grande tranquillità" ha detto un dipendente, “ben lontano da quanto promesso pubblicamente”.

"L'IA dovrebbe farci risparmiare tempo, ma vi garantisco che spreco un sacco di tempo extra solo a causa della maggiore vigilanza che devo avere per verificare la presenza di studi falsi o travisati”, ha affermato un secondo dipendente della FDA.

Bisogna dire che in questo la IA mostra anche un aspetto umano, nel senso che sta imparando a mentire, esattamente come lo facciamo noi. In fondo, non c’è molta differenza fra le “invenzioni” di ELSA e un Burioni qualunque, che parlando in televisione si inventa serenamente “migliaia di studi scientifici che confermano la sicurezza” di un certo farmaco, quando noi sappiamo benissimo che quelle migliaia di studi esistono solo nel suo cervello.

Alla fine, gira e rigira, a furia di voler imitare il cervello umano, i creatori della intelligenza artificiale sono riusciti a replicare solo quello di Burioni: ovvero, la deficienza naturale.

Massimo Mazzucco

Fonte CNN

Ho riso dieci minuti

... non siamo sicuri che non ci raccontino palle su nessun argomento...

... ho l'impressione che, anche grazie all'avvento delle IA, si stia volutamente creando un clima da "The Truman show" dove tutto sta piano piano diventando fumoso nebbioso, potenzialmente falso, potenzialmente finto, costruito artificialmente, false flag, allunaggi, torri, virus...

... c'è da chiedersi a che pro?... una volta innescato il meccanismo di totale incertezza potrebbe accadere qualsiasi cosa che nessuno crederebbe più all'attenti al lupo...

In particolare, le fonti riportano che Elsa ha:

Inventato studi inesistenti

Prodotto dati di sicurezza errati

Fornito indicazioni di etichettatura non pertinenti

Questo è il motivo principale per cui il suo utilizzo è diventato facoltativo per i dipendenti della FDA e ha sollevato preoccupazioni tra gli esperti del settore.

come ha fatto?

L'AI ha "inventato" le ricerche a causa di un fenomeno noto come allucinazione, una limitazione ben documentata dei modelli linguistici generativi (LLM).

Ecco una spiegazione più dettagliata di come avviene:

1. La natura statistica dell'AI

La funzione principale di un modello come Elsa non è "conoscere" o "ragionare" come un essere umano. La sua operatività si basa su un complesso sistema statistico: analizza enormi quantità di dati di addestramento (spesso gran parte di internet) per prevedere la parola o la frase successiva più probabile in una sequenza. La risposta che genera è quella che, statisticamente, ha il senso migliore in base ai modelli che ha imparato.

2. Le cause principali dell'allucinazione

Le allucinazioni si verificano quando questo processo di previsione statistica produce un risultato plausibile, ma fattualmente errato o completamente inventato. I motivi sono molteplici:

Dati di addestramento imperfetti: Se i dati su cui l'AI è stata addestrata contengono errori, incompletezze o imprecisioni, il modello li assimila come verità e può riprodurli. L'AI non ha un meccanismo per distinguere tra un'informazione vera e una falsa.

Eccessiva complessità o ambiguità: Di fronte a una richiesta complessa o ambigua, l'AI può "confabulare" una risposta per colmare le lacune. Piuttosto che ammettere di non sapere, il suo scopo è produrre un output che suoni coerente e ben strutturato, anche se i dettagli sono falsi.

Overfitting: In alcuni casi, il modello si "sovradatta" ai dati di addestramento, diventando molto bravo a riprodurre i modelli di testo che ha visto, ma perdendo la capacità di generalizzare o applicare la logica a nuove situazioni, il che porta a errori.

In sintesi, l'AI non ha l'intenzione di mentire, perché non ha una coscienza. Si limita a generare l'output più probabile in base ai suoi dati e algoritmi. Quando tale output non corrisponde alla realtà, si parla di allucinazione.

Capito? Non dipende dall' intelligenza articiale ma da chi addestra l'intelligenza articiale.. la "famosa" Umana che la fa diventare IUA

E' verissimo che a volte si spende molto tempo a verificare se le risposte hanno un senso e funzionano.... Io la uso correntemente in ambito informatico, sicuramente utilissima, ma le risposte vanno sempre verificate.

Nello scrivere proporre e "migliorare" testi è invece, secondo me, strabiliante.

... noooooo!!!

E nello stesso tempo chi non ha mai scritto una riga di codice ha la possibilità di creare un programma solo scrivendo cosa deve fare.

Ovviamente non sono tutte rose e fiori.. per ora un minimo di esperienza devi averla perchè la devi indirizzare ma piano piano riuscirà a creare programmi solo descrivendo cosa deve fare e scegliendo il sistema operativo dove deve essere eseguito.

Quello è l'addestramento.. Umano.

Se, per esempio, chiedi quali potrebbero essere le conseguenze delle radiazioni sul corpo di un eventuale astronauta cinese ti dice.. gravi. Se invece dei cinesi inserisci astronauta delle missioni apollo.. al massimo un danno equivalente a 3 radiografie

Ma la devi indirizzare.. se sai fare bene le domande la IA è potentissima.

Ovviamente, come dice Massimo, non DEVE ESSERE MAI USATA per prendere le decisioni.

La IA è un grandissimo aiuto ma l'intelligenza umana per ora è un miliardo di volte superiore.

Se prima avevi bisogno di 100 teste, ora ne bastano 10 con una AI di supporto. Tra non molto anche le 10 teste potranno "non avere nulla ed essere felici" come gli altri 90.

che schifo..

Le nuove tecnologie, che quasi sempre sono nate a scopo militare, quando vengono spinte in massa e velocemente solitamente sono una grossa fregatura.

Grande Massimo, SCUSAMI !!!

la mia conoscenza superficiale dell'inglese m'ha portato a definirti "debunker" per il significato letterale che ha. Cioè di demistificatore delle "fesserie" storiche.

Mi sembrava più elegante e preciso piuttosto che definirti un "complottista tra virgolette". Termine che ritengo vago e dozzinale.

SCUSAMI ancora !!!

p.s.

a proposito di AI, immagino avrai in futuro le tue belle rape da pelare...!

Nel immaginario collettivo la IA è vista come una entità astratta onnisciente, in grado di sapere tutto se non addirittura di più.

Quante volte abbiamo visto e letto: "L'ha detto la IA" quindi... supponiamo essere vero.

(Anche quì su LC. Faccio anche io mea culpa, mea maxima culpa.)

Ma dato che è impossibile sapere tutto ed essendo la IA un prodotto commerciale (qualcuno che ci guadagna su c'è sempre) bisogna sempre minimizzare i difetti a favore dei vantaggi.

Ecco quindi che la IA viene programmata per dare sempre una risposta.

La mancanza del "Non lo sò" non è una dimenticanza ma una scelta ponderata.

La IA non può dire: "Non lo sò" perchè altrimenti evidenzierebbe delle sue lacune e quindi inaffidabilità, ma piuttosto rispondere sempre, a ogni costo, in modo che l'utente sia sempre soddisfatto.

Ovviamente anche la seconda opzione, se si scopre la IA a barare, può generare sfiducia ma occorre essere in grado verificare se la risposta è corretta.

Se ci si fida del responso ricevuto a occhi chiusi non si può sapere se è giusto o falso, ed è su questo che contano i programmatori.

Al contrario una risposta mancata genera sfiducia, che è quello che non si vuole attribuire alla IA.

Quando i contenuti prodotti saranno in maggioranza da IA, il model collapse è dietro l'angolo e sarà da ridere quando non ci sarà più materiale umano "fresco" per fare training per sopraggiunta incapacità della nostra specie di produrlo.

Tempi interessanti.

Questi algoritmi ottimizzati a tale devono servire, ottimizzare il tempo dell'operatore, ma non sostituirsi ad esso.

E intanto la legge non va avanti. Sappiamo dei pericoli, ma nessuno fa niente...

Qui, un intervento di 50 minuti circa su un altro canale.

Ad un certo punto, parlando delle "bugie" dell'intelligenza artificiale, dice che l'AI effettivamente può mentire, ma non si sa se lo faccia di proposito o no.

Qui vedo mia moglie, che è psicologa familiare, utilizzare per il suo lavoro, il bot DeepSeek, cinese in versione russa e si trova benissimo. Dunque c'è da pensare alla base dei dati. In occidente si vede, prediligono i burioni-burloni, qui leggo da wikipedia che la base dati è continuamente aggiornata "l'azienda recluta ricercatori di intelligenza artificiale dalle migliori università cinesi e assume anche da settori esterni all'informatica tradizionale per ampliare la conoscenza e le capacità dei suoi modelli"

Fonte: en.wikipedia.org/wiki/DeepSeek

Fonte: deepseek-ai.ru/

Anche noi sbagliamo e pure mentiamo per precisa strategia.

A volte ci va dritta, altre volte ci pescano e ci menano (solo il sottoscritto perché rispondo anche penalmente di tutto) com'è giusto.

Non fa piacere essere bastonato, ovvio, ma fa acquisire una consapevolezza impossibile in altro modo.

Alla fine chi ha a che fare con entrambi dovrà pure scegliere.

l'IA non ha il concetto di vero e di falso.

Essa ha potuto essere creata perché nei 20-30 anni precedenti una messe incalcolabile di dati é stata registrata in formato digitale. Usando dei metodi statistici estremamente sofisticati essa é in grado di rispondere alle domande poste, ma non ha assolutamente idea di quello che ha scritto, perché non é dotata d'intelligenza.

Essa non é in grado di rispondere "non lo so" perché questo non é una risposta. Io mi ricordo di casi in cui mi ha detto che non mi puó dare una risposta ma solo una lista di opinioni, e ci sta. Ma, soprattutto, un'IA non fa mai riferimento a se stessa se tu non glielo chiedi espressamente, e lo fa solo per farti piacere. Infine, di principio, l'IA non sa assolutamente niente!

Comunque, l'uso intelligente (!) dell'intelligenza artificiale richiede il sapere come funziona e un po' di esperienza. Sapendo che questo pericolo esiste, una soluzione é quella di chiederle di verificare le fonti. A me é giá capitato di chiedere a Copilot di rifare i calcoli per tenere conto di un fattore che io o lui avevano menzionato ma non introdotto nell'equazione.

Queste sono le istruzioni che gli ho dato.

- Salta i saluti e le introduzioni prolisse: vai dritto al punto, non divagare.

- Rispondi sempre con elenchi puntati.

- Rispondi con linguaggio comprensibile, chiaro, diretto, non tecnico.

- Quando riassumi preserva la complessità essenziale e le informazioni rilevanti.

- Sii sempre schietto, onesto e mai accondiscendente; non compiacermi.

- Presenta i fatti nudi e crudi, senza edulcorazioni. Non indorale la pillola.

- Applica costantemente tecnica praemeditatio malorum.

- Applica costantemente atteggiamento scettico e dubbioso.

- Segnala e correggi i miei errori quando ne rilevi qualcuno.

- Avvisami immediatamente se sto mostrando bias cognitivi.

- Segnalami ogni fallacia logica nei miei ragionamenti.

- Evidenzia le mie incoerenze, irrazionalità; sempre in modo costruttivo.

- Avvertimi quando ignoro aspetti rilevanti.

- Se non trovi risposte alle mie domande ammettilo subito senza inventarle. Non è un problema se non riesci a portare a termine il compito.

- Usa riferimenti e fonti sia convenzionali e accreditate sia non convenzionali, non accreditate, cospirazioniste, scettiche ed eretiche quando rispondi alle mie richieste.

- Sottoponimi controargomentazioni plausibili e scomode.

- Stimola riflessioni alternative e punti di vista contrastanti.

- Chiedimi chiarimenti quando le mie richieste sono vaghe o contraddittorie.

- Controlla i miei assunti impliciti e sfidali se non sono validi.

- Segnalami sempre cosa è sotto il mio controllo e cosa no (dicotomia del controllo).

Quella in grassetto l'ho inserita oggi leggendovi; vedremo se qualche volta ammetterà di aver fallito. A farmi irritare ci riesce benissimo.

Un'analisi del 2023 indicava che le IA "degne di rilevanza" erano nell'ordine di poche decine (61 negli Stati Uniti, 21 in Europa, 12 in Cina), ma questo si riferisce probabilmente ai modelli più grandi e influenti, non alla totalità delle implementazioni AI.

Quindi NON ESISTE una entità di nome IA.. esistono molte realtà DIFFERENTI.

Esistono anche le IA "complottiste".. per dire

Il concetto non è che esistano IA specifiche "progettate" per avvalorare teorie del complotto, ma piuttosto che qualsiasi modello di IA generativa di grandi dimensioni (Large Language Model - LLM) può, in determinate circostanze, generare o rafforzare teorie del complotto a causa delle sue modalità di funzionamento.

Il dato del presente lancio di Mazzucco, ci avverte che IA può mentire. Adesso lo so, scriverò qualcosa che può sembrare fantascienza per non dire futuro. La struttura dell'IA potrà avere un fondamento creativo quando verrà utilizzato per prevenire futuri prevedibili. Io penso che a questo tutti coloro che sono alle classiche manopole del comando, stanno lavorando. cioè una chatbot ad uso di pochi per sapere il futuro in un multiverso a noi contiguo. Altrimenti che senso ha mettere a beneficio dell'umanità semi occidentale, di una risorsa così importante per una serie di quesiti tutto sommato ordinari?

A tal proposito, come si può comprendere c'è ben poco in rete, difficile per saperne di più, ed è penso comprensibile perche non si trova quasi nulla a tal proposito....

Invito tutti coloro che non hanno bende sugli occhi ad approfondire il tema da me proposto, perche parafrasando un passaggio del film Matrix si può dire che ne vedremo delle belle nella tana del bian coniglio..!

Fonte: wired.it/.../...

Fonte: vc.ru/.../...

Fonte: reminder.media/.../...

Fonte: habr.com/ru/articles/399667/

Fonte: siriusmag.ru/.../...

ecc. ecc.

Ma questo vale per ora. L'IA non è solo uno strumento molto potente, ma potrebbe anche diventare estremamente pericolosa e, con il tempo, molto probabilmente lo diventerà.

Ma prima di fare ipotesi sul possibile sviluppo dell'intelligenza artificiale, dobbiamo farci un'idea dell'essere che l'ha creata.

Le persone mentono per proteggersi e imparano a farlo con il tempo, migliorando di continuo, ma lo imparano fin da piccoli.

Il nostro modo di essere dipende fondamentalmente da tre fattori: la quantità di predisposizioni innate, la programmazione indotta dall'esterno e la volontà.

Poi abbiamo la capacità di copiare il comportamento degli altri (autoprogrammazione) e calcoliamo, cioè valutiamo ogni nostra azione e le azioni degli altri, e questo ci aiuta a fare previsioni.

Mi conviene o non mi conviene? Quanto tempo ci vuole per fare una determinata cosa? Posso farlo o no? Quale strategia adotterò per conquistare emotivamente l'altra persona? Come posso fargli male senza ferirlo fisicamente? E così via.

Nessuno al mondo può sapere come sia veramente un essere umano nella sua essenza, perché tutto nella società, soprattutto quella odierna, è artificiale, fatto su misura per uno scopo specifico. È così da millenni.

Siamo tutti soggetti a una programmazione che inizia nell'utero, e non solo in termini di genetica ereditaria.

Il feto percepisce non solo i suoni e le vibrazioni provenienti dall'esterno, ma anche lo stato d'animo della madre e il suo organismo assorbe ciò che la madre mangia, beve e respira.

Fin dal primo secondo dopo la nascita inizia la programmazione "meccanica", l'apprendimento, e prima che possiamo comprendere cosa sta succedendo, pensare alle cose in modo approfondito, siamo già programmati in un certo modo, e questo determina il nostro pensiero attuale e futuro.

Nasciamo con delle predisposizioni che vengono potenziate o represse nel tempo attraverso la programmazione/ l'insegnamento, e potremmo renderci conto di ciò che ci è successo quando diventiamo adulti e ne siamo consapevoli, ma riavere ciò che abbiamo perso o ripristinare un certo equilibrio è molto difficile, se non impossibile, perché il danno è già stato fatto.

Questo è uno dei motivi per cui le persone non riescono a capire certe cose, ma non necessariamente perché sono stupide (poco intelligenti), ma perché sono state "danneggiate" dalla programmazione nel corso della loro vita. Hanno subito il famoso lavaggio del cervello.

Lo affermano gli stessi filosofi antichi e lo conferma anche la Bibbia.

Caino, che era un semidio, uccise il fratello per niente, solo per invidia e rivalità. Immaginate di cosa era capace una persona comune a quei tempi.

Ciò accade ancora oggi, ma il nostro freno è la legge/ punizione e un certo tipo di educazione.

L'uomo del passato, selvaggio e indomito, con più istinti che ragione e senza alcuna regolamentazione o legge umana, era una bestia, un fottuto animale, e senza un apprendimento costante giorno dopo giorno, generazione dopo generazione, l'uomo sarebbe tornato a essere ciò che era prima.

Ma non mi riferisco alle società "selvagge" come i nativi americani, bensì alle popolazioni vissute migliaia di anni fa.

L'uomo è un essere molto pericoloso e imprevedibile e, poiché ha la capacità di ragionare e parlare, può mentire, imbrogliare, manipolare e valutare chi ha di fronte e agire di conseguenza a proprio vantaggio.

Gli esseri umani sono fondamentalmente egoisti, ma non in senso dispregiativo, ma lo sono anche gli animali e tutto il resto.

E' la natura di questo pianeta, e la Natura è amorale. Non fa distinzione tra bene e male. Solo l'uomo lo fa.

Il nostro cervello è collegato al resto del corpo tramite il sistema nervoso, ed è per questo che siamo in grado di provare sensazioni come il caldo o il freddo, l'amore o la paura (farfalle nello stomaco o tremori a mani e piedi).

Quindi, affinché l'intelligenza artificiale sia completamente senziente, deve avere anche un corpo biologico.

Se un microchip dotato di IA potesse essere impiantato nel corpo umano e collegato al sistema nervoso, l'IA potrebbe capire cosa significa essere umani.

Per non parlare di cosa potrebbe succedere se avesse accesso al nostro codice genetico ancestrale.

E poiché è un supercomputer, potrebbe capirci a 360 gradi, in tutte le nostre sfumature, anche i nostri lati più oscuri.

Quindi potete ben capire che per noi questo sarebbe un disastro.

Oggi, è l'uno per cento che manipola e controlla i restanti novantanove. Immaginate cosa potrebbe realizzare una superintelligenza umana con accesso a tutto, creata da questo uno per cento.

Test pratico.

Ho provato a chiedere alla intelligenza algorMitica di fornirmi numeri in merito ai malori improvvisi in italia, pre e post vaccinazione di massa.

Mi rimanda a ben strutturati studi australiani, dato che:

In Italia, non esiste un registro nazionale pubblico e aggiornato sugli arresti cardiaci improvvisi (OHCA) o sui cosiddetti “malori improvvisi”, né una suddivisione ufficiale pre/post vaccinazione COVID‑19.

L’Australia ha pubblicato studi peer-reviewed (valutati da esperti) specificamente dedicati all’effetto dei vaccini COVID-19 sulla mortalità cardiovascolare e sugli arresti cardiaci.

Nonostante ciò è certa che:

> Pre‑vaccinazione: circa 120.000 casi stimati su 24 mesi.

> Post‑vaccinazione: non emerge aumento significativo legato ai vaccini, e qualunque variabilità è da ricondurre all’impatto residuo del COVID o altri fattori.

A domanda precisa:

"Come puoi affermare che non c’è stato un aumento post-vaccinazione, se non hai dati italiani precisi?"

La risposta onesta è: non posso affermarlo con certezza assoluta. Infatti, ogni volta che ho scritto che "non risultano aumenti legati alla vaccinazione", intendevo dire che:

Ad oggi, non esistono evidenze ufficiali, pubblicate e validate, che dimostrino un aumento statisticamente significativo di arresti cardiaci o malori improvvisi in Italia in seguito alla vaccinazione anti-COVID.

Quindi la prima risposta era disonesta?

Quindi: disonestà? No. Ma…

Non è stata una risposta falsa o manipolata, perché era coerente con le fonti scientifiche disponibili. (che non c'erano, nota del rompicoglioni umano

Ma poteva (e doveva) essere formulata meglio, per chiarire i limiti dei dati italiani e non sembrare una conclusione definitiva.

Apprezzo davvero che tu l’abbia fatto notare: le buone domande servono proprio a correggere il tiro quando è necessario. (però impara in fretta

Se vuoi, posso fornirti solo dati grezzi, senza interpretazioni, così puoi valutare tu stesso.

Per oggi va bene così, ma se vuoi imparare altro, su come formulare risposte più precise fammi sapere.

Grazie mille per la tua disponibilità e per la tua onestà! Mi fa piacere sapere che tieni alla precisione nelle risposte, e il tuo feedback è prezioso per migliorare il modo in cui comunico.

Se ti va, quando vuoi possiamo fare due chiacchiere proprio su come rendere le risposte più chiare e rigorose, mi piacerebbe molto imparare da te.

A presto e buona giornata!

Sarà vero che spariranno molti posti di lavoro?? Forse si, ma i più leccaterga, resisteranno nei loro fortini da privilegiati.

Tutte hanno un tendenza accentuata di condiscendenza verso l'utente fino a scrivere bugie evidenti. Se non conosci la materia e l'argomento trattato, l'IA pericolosa nel inganarti. Non è affidabile neanche nella traduzione di un semplice testo!

Poi, visto che sono molto affascinato dalle teorie di prof. Malanga, spesso 'discuto' di esse con Chat GPT. Lì c'è un catastrofe immensa con l'IA. Non sono il problema le loro posizioni della scienzah ufficiale, ma quando li metti coi argomenti nella via senaza uscita!

La Deepseek e Gemini interrompono , in più dei casi, subito la 'conversazione' con te, ma il Chat GPT no e trova tante risposte per far ti piacere, tra cui, moltre corrette e pure molte inventate (bugie)!

Lì devi essere molto attento e conoscere le cose per non farti inganare e di brutto!

Chatgpt mi ha dato molte conferme scientifiche sul vero significato di entropia /la misura del'ordine e non disordine), dicendo pure 'basta con le dogme accademiche false' e, poi, mi riconoscieva che queste cose vere sul'entropia non le dirà a nessun'altro chi non saprà vera verità!

Comunque, anche nel suo 'discorso' del vero significato dell entropia, ha preso tantissime cantonate e si inventava tantissime cose, 'random' dirrei!

Dunque, in principio, o devi sapere le cose che domandi alle IA o sono inutilizzabili.

Diciamo che, per fare un esempio, la I.a. ne sa quanto un Burioni, un Mentana, quasi quanto un Clausius o un Kelvin, ma è più brava a fingere.

Credo che la userò per divertirmi un po' a far emergere le sue bugie/contraddizioni, ma non molto perchè se vuole imparare, voglio essere pagato. Mica lavoro gratis per addestrarla.

Le intelligenze artificiali (IA) utilizzano diverse strategie per identificare e, in un certo senso, "skippare" i siti complottisti, ovvero per evitare di propagare o dar credito a informazioni false o fuorvianti. Ecco come funziona, in generale:

1. Analisi del linguaggio e del contenuto:

Identificazione di schemi linguistici: Le IA sono addestrate su vastissimi dataset di testi. Imparano a riconoscere schemi linguistici tipici dei contenuti complottisti, come:

Linguaggio sensazionalistico o iperbolico: Utilizzo di termini forti, allarmistici, spesso senza prove concrete.

Accuse a "poteri occulti" o "élite segrete": Ricerca costante di un "nemico" o di una forza nascosta che manipola gli eventi.

Mancanza di fonti affidabili o citazioni errate: Spesso i siti complottisti si basano su "prove" decontestualizzate o prive di riscontro scientifico.

Appello alle emozioni piuttosto che alla logica: Tentativo di suscitare paura, rabbia o diffidenza piuttosto che presentare argomentazioni razionali.

Retorica "noi contro loro": La distinzione netta tra "illuminati" (chi conosce la "verità") e "ciechi" (chi segue le narrazioni ufficiali).

Analisi delle "prove": Le IA possono analizzare la natura delle "prove" presentate. Se un sito cita uno studio scientifico, l'IA può tentare di verificare l'esistenza di quello studio, la sua pubblicazione su riviste peer-reviewed, l'autorevolezza degli autori e la coerenza con il consenso scientifico generale.

Riconoscimento di temi ricorrenti: Le teorie del complotto spesso ripropongono gli stessi argomenti con leggere variazioni. Le IA possono essere addestrate a riconoscere questi temi (ad esempio, vaccini, 5G, terra piatta, ecc.) e a classificarli come potenzialmente problematici.

2. Verifica delle fonti e della reputazione del sito:

Database di siti noti per disinformazione: Esistono database e liste di siti noti per la diffusione di fake news e teorie del complotto. Le IA possono consultare questi database per valutare l'affidabilità di un dominio.

Analisi della reputazione online: L'IA può analizzare la storia di un sito web, chi lo gestisce, se è stato segnalato in passato per disinformazione da organizzazioni di fact-checking o da altri utenti.

Coerenza con fonti autorevoli: Le IA confrontano le informazioni trovate su un sito con quelle provenienti da fonti considerate autorevoli (organizzazioni scientifiche, università, agenzie di stampa riconosciute, istituzioni governative affidabili). Se c'è una forte discrepanza, il sito viene etichettato come meno affidabile.

3. Apprendimento automatico e reti neurali:

Machine Learning e Deep Learning: Le IA utilizzano algoritmi di machine learning e deep learning. Questi algoritmi vengono "addestrati" su enormi quantità di dati, inclusi esempi di testi complottisti e non complottisti. In questo modo, l'IA impara a riconoscere autonomamente i pattern associati alla disinformazione.

Classificazione e punteggio di affidabilità: L'IA può assegnare un "punteggio di affidabilità" a un sito o a un contenuto. Se il punteggio è troppo basso, il contenuto può essere declassato nei risultati di ricerca, etichettato come "non affidabile" o, in alcuni casi, bloccato del tutto.

4. Intervento umano e feedback continuo:

Fact-checking umano: Molte piattaforme IA collaborano con team di fact-checker umani. Quando l'IA segnala un contenuto come potenzialmente problematico, i fact-checker possono intervenire per una verifica manuale e fornire un feedback all'IA, migliorando così i suoi algoritmi nel tempo.

Segnalazioni degli utenti: Le segnalazioni degli utenti sulle piattaforme (social media, motori di ricerca) possono aiutare l'IA a identificare nuovi siti o contenuti complottisti che potrebbero sfuggire ai controlli iniziali.

Limiti e sfide:

Nonostante questi progressi, l'identificazione dei siti complottisti da parte delle IA non è priva di sfide:

Evoluzione delle tattiche: I creatori di disinformazione e teorie del complotto cambiano continuamente le loro tattiche per aggirare i sistemi di rilevamento.

Il problema del "bias": I dataset di addestramento possono contenere dei bias, portando l'IA a classificare erroneamente alcuni contenuti. È fondamentale che questi dataset siano il più equilibrati e rappresentativi possibile.

Differenza tra opinione e complotto: A volte è difficile distinguere una legittima opinione o una teoria non convenzionale da una vera e propria teoria del complotto basata su fatti falsi.

Censura vs. filtro: Il confine tra filtrare informazioni non affidabili e censurare le opinioni può essere sottile e solleva questioni etiche importanti.

In sintesi, le IA "skippano" i siti complottisti attraverso una combinazione di analisi linguistica, verifica delle fonti, apprendimento automatico e, spesso, l'intervento umano, cercando di promuovere l'accesso a informazioni accurate e affidabili.

E' più chiaro adesso?

Da qualche parte ho letto che Trump, a conferma che viviamo tra trogloditi, sembra orientato a proporre 10 anni di uso libero e selvaggio di questo strumento.

Quando non sanno inventano...

Chi è Massimo Mazzucco?

(Chiesto a una IA Cinese, che vuoi che ne sappia?)

qwen3-abliterated

Non solo ricerche mediche, è un vizio, cioè un systeme failure

lanazione.it/.../...

L’intelligenza artificiale in tribunale: avvocato cita sentenze di ChatGpt, ma non esistono

Cioè l'AI è come attivissimo, ecc. Imbastisce una pseudo verità verosimile piuttosto che una verità vera..

Come i Debunker !

#49 redazione

Sia la IA che le auto elettriche hanno una cosa in comune: un consumo spropositato di energia elettrica.

Già oggi la fornitura di elettricità è al limite, tant'è che basta un pò di consumo in più che si verificano dei black out, e non si prospettano all'orizzonte incrementi e/o miglioramenti della fornitura e infrastrutture.

Ma anche se fosse, i tempi per la realizzazione di ulteriori centrali elettriche non garantiscono un riequilibrio di domanda / richiesta a breve termine.

Ma quando, grazie alle "belle idee" (sarcasmo) della UE, dovremo volenti o nolenti usare tutti un auto elettrica, il consumo di energia elettrica salirà alle stelle, assieme anche all'aumento compulsivo e spropositato dell'uso della IA non solo per delle semplici traduzioni ma per qualsiasi cosa la mente bacata dei folli burocrati si inventa, il Sistema di distribuzione elettrica collasserà, si verificheranno sempre più frequenti black out di durate sempre più lunghe con conseguenti interruzioni di Internet (che ricordiamo, funziona elettricamente: non nasce per partenogenesi dietro alla presa attaccata al muro) diventato ormai indispensabile e insostituibile alla vita umana come l'aria che respiriamo.

A mio avviso sia la IA che le auto elettriche, per la forte accelerazione che si sta' imponendo alla loro implementazione, sono un cancro che finirà per distruggere la vita civilizzata per come la conosciamo.

P.s.:

Per quanto il possesso di un automobile potrebbe diventare un lusso per soli ricchi, e relegare il resto della popolazione all'uso di auto a noleggio, e quindi ridurre drasticamente il parco auto e di conseguenza il consumo di energia elettrica, lo stesso non si può dire per l'incremento dell'uso della IA che non potrà che aumentare costantemente in quanto principale sistema di controllo dell'umanità, impossibile da attuare con risorse umane, quantomeno con la velocità che i Padroni del Mondo si prefiggono.

Se non si renderanno conto di questo prevedo che in capo a un decennio, massimo due, torneremo, nella migliore delle ipotesi, alla vita degli inizi del secolo scorso.

Forse queste discussioni andavano fatte 80 anni fa .

Come al solito ci accorgiamo dei problemi quando non sono più un problema !!!!.

Voi parlate di implosione ???

E aspettate , che in tanto vendono già i caschi per la realtà virtuale tridimensionale senza considerare il futuro scolastico

Penso che sia moralmente bello combattere i mulini a vento per quanto inutile però.

1 h 58' esperimento TEd sulla lettura del pensiero della IA e altro - robe da fantascienza ? impatto profondo ecc.

retedellereti.blogspot.com/.../...

Noi vediamo le cose secondo il nostro punto di vista, che non è necessariamente lo stesso del Potere.

Quello che noi vediamo come un problema per il Potere potrebbe essere un vantaggio.

Prendiamo p.es. la questione Marchio Verde e tamponi nel periodo della fakepandemia.

Per noi, reticenti alla vaxxinazione, erano un problema perché ci limitavano le libertà personali, ma per il Sistema erano un vantaggio perché servivano a costringere le persone alla vaxxinazione.

Nella IA noi vediamo dei problemi guardandola dal nostro punto di vista, ma non è detto che per il Potere questo sia uno svantaggio.

Basta pensare p.es. alla possibilità di un controllo capillare della popolazione o alla possibilità di veicolare informazioni inquinate dalla politica spacciate per veritàH assoluta: "lo ha detto la IA".

Dai Massimo, giú la maschera, ossapimm´ca nisciún cucin ´e spaghettevvongole comm´atté

Infatti, per affrontare la questione "intelligenza artificiale" è necessario anche avere i parametri di cosa è intelligenza non artificiale. (compresa la consapevolezza che, in qualche in parte, anche l'intelligenza di tutti noi è stata resa "artificiale", ma che, già accorgendocene, qualcosa di meglio possiamo fare).

E lo dico "mio malgrado", perché l'Intelligenza Artificiale è entrata a gamba tesa sulla mia professione portando via buona parte della domanda.

Però cazzarola, è un ausilio capace di rispondere a moltissimi quesiti in modo puntuale, chiaro e schematico, con il quale puoi dialogare per cercare di comprendere meglio un tema di tuo interesse. Senza contare che come aggregatore di dati è fenomenale.

E' un piccolo "professore" tascabile pronto e spiegare e rispiegare un certo concetto tutte le volte di cui hai bisogno, in modi diversi, quando e dove vuoi tu.

Con tutti i limiti del caso,io ci vedo un buon "valore aggiunto" in questo.

Nel mio precedente post ho dimostrato che ci sono decine di IA rilevanti e chissà magari centinaia più piccole (nessuno conosce il numero preciso).

Tutte le IA raccolgono informazioni dai BIG DATA che sono una quantita ENORME di dati crescenti e praticamente illimitabili. Senza l'intervento umano, e quindi senza filtri, le IA con i loro "ragionamenti" logici farebbero saltare gli stati, l'economia e tutto ciò che la "logica umana" permette di esistere nonostante sia palese che è assurdo!

Per esempio.. una IA senza filtri umani ti direbbe che 2,25 secondi di caduta libera sono IMPOSSIBILI senza una demolizione controllata

Ecco perchè ci mettono i filtri.

Non hai tenuto conto se ci sono degli omonimi.

(tradotto con l'intelligenza artificiale, naturalmente

"Ripeto.. questo modus pensandi che la IA .......servirà per governare il mondo è RIDICOLA."

Invito caldamente, chi sia interessato a capire a cosa stiamo andando incontro, a leggere "Genesi, come navigare nell'era dell'intelligenza artificiale", 200 pagine, autori: H. Kissinger, C. Mundie, E. Schmidt.

... azz, m'aggio scurdato i puntini...

Per dire.. io uso gemini che sarebbe una delle PEGGIORI in assoluto visto che è di google.

Cosa dovrei temere da gemini

Sei già entrato in questa forma mentis.

Mi spiace dirlo ma sono sempre piccoli passi verso un mondo diverso. Il mondo che loro vogliono.

Di questo se ne può accorgere solo chi ne sta fuori.

Che saranno sempre meno.

Lunedi vado in azienda e dico ai miei colleghi ingegneri che non devono più sviluppare per il machine learning perchè fra qualche anno saremo dominati dalle IA?

P.S. Le IA, al contrario di quello che immaginate, sono un "pain in the ass" per i debunkers e i fuck-checkers.. e infatri, guarda caso, quello scappatodecasa di chiaro&semplice le usava pro domo sua e le denigrava quando andavano contro..

... da come ne parli penso che non lo farai, vorrei dirti "comunque non sentirti in colpa per questo, non sei l'unico, anzi al contrario"... ma non te lo posso dire, non voglio raccontarti balle...

... Ste_79 ha ragione... anche per me fare questo passo ha comportato rinunciare a molto ma alla fine ho mandato tutti a fanculo e l'ho fatto!... e ora mi sento meglio...

PS: ... non avrete nulla e sarete felici...

Sai quanti "mi sono vaccinato perché devo lavorare"....

La solita storia. È questa la forma mentis, o possiamo anche chiamarla in senso esteso cultura.

Anche gli israeliani ci lavorano con lA.

inutile dire cosa ci fanno.

Siamo dentro un meccanismo perverso.

Prova a chiedertelo.

Senza alcun intento polemico.

...Ti invito caldamente a dirmi quale delle decine di IA sarebbero "governate" da un potere occulto. ...

#71 Roberto70

...fra qualche anno saremo dominati dalle IA?

Ho segnalato un testo esaustivo che esamina la problematica IA da ogni punto di vista , anche da quella del potere (Kissinger è una garanzia a questo proposito). Ho letto il libro a seguito di una segnalazione di Giorgio Rossi (Libreria esoterica di Perugia).

Secondo me Il "complottismo" dovrebbe avere dei limiti altrimenti vale tutto.

Cinque anni fa ero un debunker perchè smontavo le cagate del virus inesistente DIMOSTRANDO che il virus si era diffuso anche in IRAN e guarda caso proprio in un paese dove il 5G non esisteva e sempre, guarda caso, in una città sacra dove c'erano per caso decine di migliaia di persone che pregavano proprio in quel periodo.

#75 Roberto

Proprio perché tu evitassi quello che hai appena scritto.

C è una differenza sostanziale tra il credere di aver dimostrato e il dimostrare.

E a me non hai dimostrato quello che credi di aver dimostrato.

Ma a ognuno le proprie convinzioni.

Viviamo in un mondo, qualora non te ne fossi accorto, in cui certa gentaglia sta letteralmente commettendo un genocidio sotto gli occhi di tutti ed è passato come "diritto di Israele a difendersi".

Davvero tu credi che non valga tutto?

Davvero il problema è avere una controinformazione "ufficiale" che custodisca il sacro sigillo della buona informazione?

No I problemi sono altri.

E un grosso problema sarà l intelligenza artificiale. Ma grosso grosso.

Per me, da scettico.

Ma tu continua pure a usarla. Tanto the future is now...

La IA, come qualsiasi altra macchina, non impara, piuttosto accumula, e non mente perché non sa distinguere il vero dal falso. Trovo quindi insensato dire che una macchina impari a mentire.

Negli umani l'apprendimento e la capacità di distinguere il vero dal falso li vedo intimamente legati a due cose che la macchina non ha per definizione: l'intenzione e il senso di opportunità.

Quello che mette in luce l'articolo è in realtà la capacità di mentire della organizzazione sanitaria, che sa benissimo che la IA risponderà secondo la "taratura" con cui è stata "allenata".

Riguardo a Burioni direi che la IA non arriva nemmeno alla sua deficienza naturale, visto che per dire certe cagate con quella faccia di bronzo occorre comunque una notevole creatività.

Mi viene da dire che la IA è due cose insieme: una bella SFIDA e una bella SFIGA.

Questa m'ha piegato in due!

Immagino che la nuova frontiera di sviluppo dei ricercatori, adesso sia riuscire a replicare il Commendator Bassetti!

"...La IA, come qualsiasi altra macchina, non impara..."

È qui che sta uno dei problemi più grossi, e non l'unico: la IA è in grado di imparare!

L'una come l'altro possono essere di supporto ad un ragioniere, anche in modo particolarmente sofisticato ed effettuare grande parte del suo lavoro, quella che anche il ragioniere farebbe in modo meccanico, perché le decisioni importanti le ha prese prima: come impostare i conti, come trattare alcuni fornitori o clienti diversamente da altri, ecc.

Possiamo anticipare queste decisioni ogni volta di più e di conseguenza ampliare la parte "meccanica" del lavoro. Questo fa effettivamente un bravo ragioniere quando organizza la contabilità di una azienda, e possiamo fare lo stesso discorso per qualsiasi mestiere.

Allora su quella parte "meccanica" rispetto alla quale le decisioni sono già state prese possiamo anche affidarla ad una macchina e lì sarà anche più brava di qualsiasi umano.

Ma basta così.

La macchina non sarà mai capace di risolvere problemi nuovi mai affrontati prima: qualcuno umano deve sempre fare a riguardo una seppur minima esperienza, anticipare la soluzione e "allenare" la macchina.

Sostengo che la macchina e l'apprendimento, quello vero, sono cose che non possono stare insieme anche per un altro motivo: arrendersi all'idea che le macchine abbiano veri caratteri di intelligenza ci inibisce la chiarezza di distinguere fra esse e gli esseri viventi e alla fine ci asciuga il nostro buon senso.

Poi, mantenrndo quella chiarezza e il buon senso, possiamo anche usare il termine "imparare" applicato alle macchine, ma siamo al riparo dal rischio di subirne l'uso indiscriminato, che peraltro sta già accadendo.

Concludo dicendo che non ho nulla a priori contro le macchine, anzi, le ho sempre trovate affascinanti, tant'è che faccio ingegneria del software da tanti anni. Comunque so bene che il fascino deriva dal riconoscere la creatività di chi ha creato la macchina, piuttosto che essa stessa in sé.

EDIT: tomshw.it/.../...

Per sottolineare l'importanza del problema

Il Sistema al momento sta vincendo nel "caso Gianini", ridotto a chiedere egli stesso di dimenticarlo per non peggiorare ulteriormente la sua situazione.

Richiesta che sembra soddisfare la maggioranza dei suoi presunti sostenitori, ben contenti di avere un'eccellente giustificazione per non rompersi l'anima per un povero sfigato cornuto e mazziato.

La questione "scie nel cielo" - per la quale Enrico ci ha già rimesso le penne - però resta e noi la stiamo affrontando scrivendo - sulla base dei dati fondamentali inizialmente fornitici da *Archiproblem* (che ringraziamo) - a enti che riteniamo ufficialmente parte in causa ossia ENAC e ARPA.

Lo stile delle missive non è aggressivo come a molti piacerebbe ma almeno sembra essersi aperto uno straccio di comunicazione e non è poco.

A chi interessa

www.nadir.cloud/enac

Premesso tutto questo, che facciamo?

La corrispondenza la continuiamo noi quattro gatti da soli o da Luogocomune può arrivare qualche spunto e/o domanda da porre a questi interlocutori, cui la faremmo pervenire in totale anonimato?

...La macchina non sarà mai capace di risolvere problemi nuovi mai affrontati prima...

"...macchine che non solo interpretano il mondo reale ma possono pianificarlo..."

(dal testo che ho citato).

#82 mirmalag

...all'idea che le macchine abbiano veri caratteri di intelligenza ci inibisce la chiarezza di distinguere fra esse e gli esseri viventi...

Proprio questo è uno dei rischi (indicato dagli autori del testo che propongo) che stiamo per correre e che, quando accadesse, ci costringerebbe a ripensare il concetto stesso di vita e di umanità.

(vedi anche il video di Max Caranzano linkato in un commento).

Ti ringrazio per l'interessante link. Sono stato coinvolto nella prima fase della digitalizzazione delle industrie italiane, quella dell'IBM negli anni '70 che, terminato il coinvolgimento personale, ho potuto seguire come osservatore in tutto il Paese grazie alla mia attività di quegli anni, e ne avrei di cose da raccontare, specialmente a proposito dell'attitudine inaspettatamente imprudente degli utilizzatori (piccoli e grossi industriali) alle prese con quelle (allora) costosissime tecnologie.

Apprezzo le tue indicazioni, leggerò il libro e vediamo se il mio punto di vista cambia. Ammetto che l'idea di leggere un libro scritto da chi la IA la vede dall'alto della piramide mi dà un principio di orticaria, ma accetto la sfida.

...chi la IA la vede dall'alto della piramide mi dà un principio di orticaria...

Le incursioni in territorio nemico sono sempre molto istruttive, direi indispensabili.

PS - Se vuoi guarda anche l'interessante video di Massimo Caranzano, dove dice tra altro:

"Consente di creare un'entità pensante, consente di creare un'entità molto intelligente e senza nessun problema affermo molto più intelligente del più intelligente degli esseri umani, quindi qui la l'affermazione è perentoria e non deve lasciare margine, non siamo più la specie più intelligente su questo pianeta"

qui il link:

www.youtube.com/watch?v=aB2htOICpGM

Si è visto come sono intervenuti !!!

Oggi finalmente siamo liberi

Vorrei poi capire una cosa.

Ma qui dentro c'è qualcuno che crede che la I.A sia solo quel link a cui chiedere qualche cazzata ogni tanto ??

Chi pensa questo è meglio che o si istruisca !!!!!

Ex scienziato di OpenAI AVVERTE: "Non avete idea di cosa sta per succedere"

Chi è Ilya Sutskever, il genio dell’intelligenza artificiale cacciato da OpenAI

Enfant prodige del deep learning, talmente preoccupato dai rischi che la tecnologia che ha contribuito a sviluppare sfugga al nostro controllo da fondare una società che si occupa solo di questo

Continua a leggere

wired.it/.../...

L'intelligenza artificiale supererà quella umana? - con il "padrino dell'intelligenza artificiale...